Randal Quran Reid conduïa per l’autopista interestatal als afores d’Atlanta (Geòrgia) quan una patrulla el va aturar. Era l’endemà del Dia d’Acció de Gràcies de 2023 i es dirigia a veure la seva família després de recollir el seu cotxe del mecànic. “Pensava que hi havia un problema amb el vehicle”, explica Reid. Després d’una sèrie de preguntes i un intent d’identificar-lo, els patrullers el van emmanillar, el van posar dins del seu cotxe i se’l van endur a la comissaria. “No em van voler donar cap més informació, a part de dir-me: ‘Hauràs d’esperar que les autoritats de l’Estat de Louisiana et vinguin a buscar’”. Totalment desconcertat, Reid desconeixia que tenia una ordre de cerca i captura per una presumpta compra fraudulenta a Nova Orleans. El principal problema, però, és que ell no havia trepitjat mai l’estat de Louisiana.

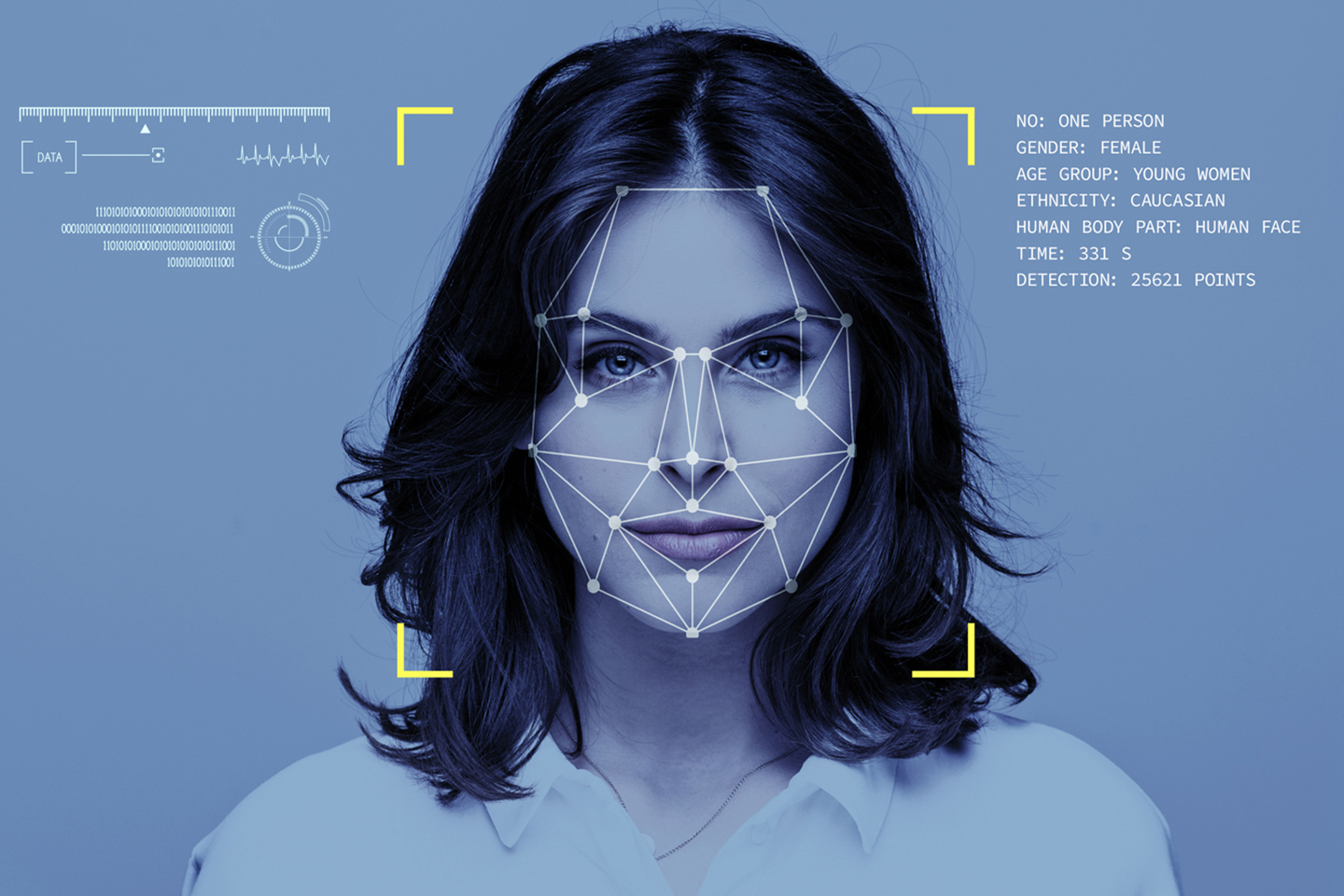

El cas de Reid és un més entre els nombrosos errors d’identificació per part dels departaments de policia dels EUA a causa de l’ús expansiu de la intel·ligència artificial (IA) i la confiança creixent en la seva efectivitat. Reid va ser identificat pel programari Clearview AI com un dels autors del delicte en comparar fotos de carnets de conduir amb les imatges preses per les càmeres de vigilància de la tenda on es va fer la compra fraudulenta. Ja fa temps que estudis i anàlisis de dades demostren que les tecnologies de reconeixement facial no són infal·libles, i des de l’àmbit acadèmic moltes especialistes es pregunten si aquesta vigilància s’està convertint en la versió 2.0 de la defenestrada política del stop-and-frisk, amb la qual la policia de Nova York tenia el poder d’aturar i escorcollar indiscriminadament a qualsevol que passés pel carrer, sempre amb un clar biaix cap a les persones no-blanques.

“Els sistemes d’IA aprenen a prendre decisions basant-se en dades d’entrenament, que poden incloure decisions humanes esbiaixades o reflectir desigualtats històriques o socials, fins i tot si s’eliminen variables sensibles com el gènere, el perfil ètnic o l’orientació sexual”, expliquen James Manyika, Jake Silberg i Brittany Presten, autores d’un estudi de la Universitat Harvard sobre aquestes tecnologies. Entre altres conclusions, les investigadores han pogut comprovar que les tecnologies d’anàlisi facial tenen percentatges d’error més alts amb certs segments de la població com les dones i les comunitats afroamericanes, perquè no estan tan representats en les bases de dades utilitzades per fer les anàlisis.

Regulació a marxa lenta

Si bé el seu ús ha crescut exponencialment en poc temps, no es tracta d’eines noves. La policia de Nova York empra tecnologies de reconeixement facial des del 2011. A més, la imatge de la gran majoria de la ciutadania dels Estats Units està en alguna base de dades governamental. De fet, l’FBI les va utilitzar per identificar molts dels individus partidaris del president sortint Donald Trump que van assaltar el Capitoli de Washington el 6 de gener de l’any 2021.

Un estudi de la Universitat de Harvard conclou que les tecnologies d’anàlisi facial fallen més a l’hora d’indentificar dones o persones afroamericanes

L’hermetisme amb què institucions i forces de l’ordre estan desenvolupant i implementant aquestes tecnologies és el que crea més desconfiança entre l’opinió pública. En molts casos, els mateixos agents desconeixen el funcionament dels algoritmes i el procés de presa de decisions. Activistes i investigadors en demanen més supervisió. “Una major transparència, regulació, auditoria i explicació de l’ús de tecnologies de reconeixement facial, i l’aplicació en contextos individuals, millorarien els desplegaments” d’aquests programes, expliquen Denise Almeida, Konstantin Shmarko i Elizabeth Lomas, investigadores de la Universitat de Londres especialitzades en privacitat, ètica i IA.

Davant la manca de directives clares sobre el desplegament d’aquestes noves tecnologies, als EUA són els estats i els municipis els qui improvisen la seva implantació a base de proves i errors. A San Francisco (Califòrnia), el Departament de Justícia va aprovar fa uns anys un programa desenvolupat en col·laboració amb la Universitat de Stanford que elimina dels documents judicials els cognoms, la raça i el color d’ulls i cabells de persones processades, així com els barris dels quals són originàries. A l’altra banda del canal, a la ciutat d’Oakland es va prohibir l’ús de la IA per predir crims. A Nova Orleans, on el 2020 s’havien prohibit les tecnologies de reconeixement facial, es va fer marxa enrere dos anys més tard davant l’augment del nombre de delictes, i tot just tres mesos abans de la detenció de Reid.

Predir un crim

Una de les grans polèmiques amb relació als biaixos de la IA rau en els programes utilitzats per policies locals per alertar de potencials crims. A Minority Report, el relat futurista de Philip K. Dick publicat el 1956, un agent prediu els delictes futurs gràcies a tres humans mutants, i acaba així amb la criminalitat. Avui, les noves tecnologies de control predictiu dirigeixen els agents policials a patrullar zones específiques, fins i tot indicant els carrers i moments del dia en què fer-ho. Aquesta política de policia preventiva intenta determinar les possibilitats futures que es cometi un crim concret en una zona determinada a partir del processament de dades existents.

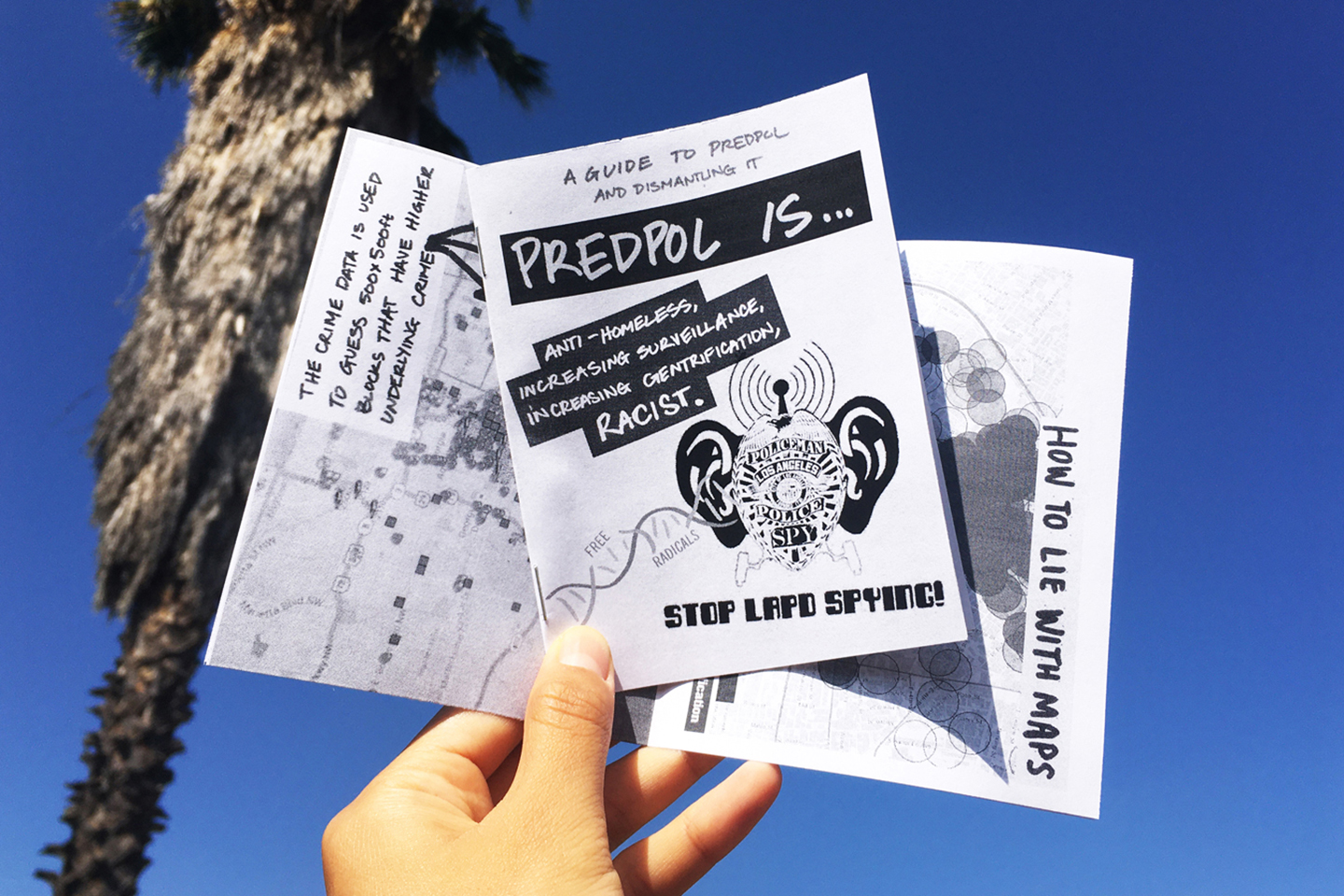

A Plainfield (Nova Jersey) la policia local usa un programa similar per fer prediccions de robatoris de cotxes, assalts o agressions amb pistola. Amb el nom de PredPol (Predicció Policial), aquest protocol utilitza en les seves anàlisis tant la base de dades interna de la policia com informació d’altres departaments governamentals.

En un dels barris de Plainfield, amb àmplia majoria de població blanca, el programa va predir onze crims. En un altre, a uns deu minuts en cotxe del primer, però on no viu gent blanca, en va predir quasi 2.000 durant el mateix període de temps. No és una excepció. Aquest patró es repeteix de costa a costa, amb àmplia disparitat de prediccions en barris d’un mateix districte depenent de la composició poblacional.

Les prediccions algorítmiques emmirallen les estadístiques de detencions per barris. Si la proporció de delictes i arrestos per capita és més acusada entre la comunitat no blanca, nombrosos estudis també han provat que, davant la sospita d’haver comès un mateix delicte, les persones afroamericanes tenen més possibilitats de ser arrestades que les persones blanques. “En general, la nostra anàlisi suggereix que l’algoritme, en el millor dels casos, reprodueix els patrons dels agents de policia”, conclou l’estudi de la Universitat Harvard. “I en el pitjor, reforça aquests patrons si es fes cas a les seves recomanacions.”

L’ús d’aquest tipus de programes per la policia ha començat a generar preocupació entre els òrgans legislatius. A principis d’any, set senadores i congressistes demòcrates van enviar una carta al Departament de Justícia federal i van assenyalar que “l’evidència creixent indica que les tecnologies de policia predictiva no redueixen la delinqüència”. “En canvi,” conclouen, “empitjoren el tracte desigual de les forces de l’ordre vers els estatunidencs no blancs”.

Les noves tecnologies de control predictiu dirigeixen els cossos policials a patrullar per zones concretes i especifiquen fins i tot l’hora del dia en què cal anar a un determinat carrer

Però aquests sistemes de prediccions no s’usen només entre els departaments de policia, sinó també en les corts de justícia. COMPAS és un altre programa que analitza el risc de reincidència d’una acusada. Els diferents barems que empra són: el risc previ al judici, utilitzant informació sobre estabilitat habitacional, situació laboral, els vincles comunitaris i ús de substàncies il·legals; les probabilitats de nous crims, i fa servir la base de dades sobre els antecedents criminals, indicis de delinqüència juvenil o la relació amb les drogues i el risc de violència després de l’alliberament, a partir del seu historial conflictiu previ, l’edat a la qual la persona va ser arrestada per primer cop o problemes en l’àmbit educatiu.

Molts d’aquests sistemes estan entrenats d’acord amb mostres que impliquen una majoria desproporcionada d’homes, i no inclou tants factors sensibles a les dones a l’hora d’avaluar la seva potencial reincidència, com ara el paper del trauma, la victimització sexual prèvia, la inestabilitat de les relacions personals o l’estrès parental. En un dels seus estudis sobre COMPAS, l’experta en matèria d’assessorament de riscos Melissa Hamilton assegura que el programa “sobrepronostica el risc de reincidència de les dones i, per tant, condueix a condemnes injustes per a les delinqüents”.

Sense responsabilitats

Quan Reid va arribar emmanillat a la comissaria d’Atlanta i el van processar, la policia li va comunicar les acusacions que pesaven sobre ell a Nova Orleans: amb tres individus més, hauria anat a una tenda per comprar de forma fraudulenta articles de luxe per valor de 12.000 euros. Reid, entre desconcertat i enfadat, va repetir que era innocent. “El policia em va mirar i va dir que semblava la mateixa persona que apareixia a la pantalla de l’ordinador”, explica. Deu la seva llibertat a la relació del seu pare amb un advocat, Gary Andrews. “Si no arriba a tenir aquest contacte –explica el mateix Andrews– hagués estat diferent”. En assabentar-se de la situació, el lletrat va agafar el telèfon i va contactar amb un amic de professió a Nova Orleans. “Em va dir que ja sabia què podia haver passat –relata– i em demanava que li enviessin les fotos”. Una ràpida cerca del seu col·lega de Louisiana va demostrar les diferències físiques entre l’acusat i l’autor del crim: l’individu de la càmera de vigilància “tenia una piga al coll i aparentava pesar quinze o vint quilos més” que Reid.

Els biaixos discriminatoris, així com el respecte a la privacitat, són dos dels elements essencials que definiran els drets de la ciutadania amb relació amb el desplegament massiu de la IA en el sistema de justícia i de seguretat. Per a Denise Almeida i les seves companyes d’investigació, les noves regulacions han d’anar en paral·lel a les ja existents en matèria de privacitat, utilització de dades, protecció de drets i contra la discriminació, però adaptant-se al nou context.

Però, quanta privacitat està disposada a cedir la ciutadania? En el seu estudi “L’ètica de les tecnologies de reconeixement facial, la vigilància i la responsabilitat en una era d’intel·ligència artificial”, argumenten que no és el mateix una empresa que desenvolupa un sistema de reconeixement facial per desbloquejar l’ordinador –que implica que la usuària accepti aquesta operació– que la instal·lació de càmeres d’identificació en espais públics sense que la població ho accepti de manera activa. “Hi haurà distinció entre les expectatives [de les persones], si es tracta d’un espai controlat i més privat on l’individu n’és conscient i se l’ha informat de forma transparent, i la utilització de sistemes de reconeixement en espais més amplis i un ús de dades més massiu”.

Mentre els governs i reguladors lluiten per controlar el desenvolupament de la IA, des de l’acadèmia i la investigació es proposen algunes mesures que podrien contribuir a equilibrar els potencials errors. Per exemple, “diversificar les persones que treballen en aquest camp, perquè aquesta gent estarà més equipada per anticipar, avaluar, i descobrir els biaixos, així com relacionar-se amb les comunitats afectades per aquests”, assenyala l’equip d’Almeida.

Reid va passar set dies en una cel·la i encara en pateix les conseqüències. “De vegades, estic al llit i no puc deixar de pensar en què hagués pogut passar si no arribo a tenir accés a un advocat –explica–. També em poso nerviós cada cop que veig una patrulla”. No hauria estat estrany, afegeix Andrews, el seu advocat, que una altra persona amb menys recursos hauria optat per declarar-se culpable per poder sortir de la presó amb una sentència lleu abans que arriscar-se a un judici i perdre’l. El contracte entre Clearview AI, l’empresa de reconeixement facial, i la policia de Nova Orleans, estipula que el programa només ha de ser un element de suport per als cossos de seguretat en la resolució de delictes. En canvi, l’agent que estava a càrrec del cas de compra fraudulenta, va llençar l’ordre de captura contra Reid amb una sola prova: la comparació fotogràfica que va oferir el programa de reconeixement facial.